Gemini, héros ou zéro?

Que faut-il retenir du nouveau concurrent auto-proclamé de ChatGPT?

C’est comme si un an après la découverte de Spiderman, on découvrait Batman…

En présentant mercredi dernier la sortie de sa nouvelle famille de modèles nommée Gemini, Google a présenté ce qui a vite été perçu comme un concurrent plus que sérieux à chatGPT.

Mais, très vite aussi, la hype est retombée : Google est accusé d’avoir truqué la vidéo de présentation de Gemini pour faire passer l’IA pour plus intelligente qu’elle ne l’était. Faute avouée par Google dans son blog1 quelques heures plus tard.

La vérité, c’est que l’algorithme phare de la famille Gemini, “Gemini Ultra” n’est pas encore disponible. Il est donc difficile de le comparer à GPT-4.

Dans ce tunnel, je vous explique pourquoi Gemini n’est pas, comme l’affirme Google, “un bond en avant significatif”2. Même s’il ne faut pas non plus voir ce modèle comme un simple effet d’annonce.

Mais, en tout cas, ça dit beaucoup de choses sur le monde de l’Intelligence Artificielle.

Au programme du jour :

Une vidéo truquée 📽️

Mes calculs sur la comparaison entre Gemini Ultra et GPT-4 🧮

Les benchmarks, qu’est-ce que c’est ? 📈

Les avantages d’un modèle multimodal 🤝

On parlera aussi de Gemini Nano 🔬

Et surtout de l’algorithme GNoME, un peu passé sous les radars 🛰️

Allez, c’est parti!

La présentation de Gemini, le casse du siècle

Une vidéo truquée

Tout était pourtant bien parti. Demis Hassabis, le père d’AlphaGo (dont on parlait dans ce tunnel), considéré comme l’une des figures les plus importantes du monde de l’Intelligence Artificielle, présente la dernière découverte de Google Deepmind : Gemini.

A ce moment là, on se dit que ce que Google s’apprête à nous montrer peut être révolutionnaire.

Venant s’appuyer sur une vidéo de démonstration impressionnante où Gemini arrive à reconnaître en direct des formes qui sont en train d’être dessinées, le grand public commence par être bluffé.

Oui mais voilà, on a appris le lendemain que la vidéo était en fait un montage. Google a coupé plusieurs scènes où une série d’indices supplémentaires était donnée à l’algorithme.

Un tel mensonge lors de la présentation rend forcément tout ce qui y est dit sujet au doute. Pourquoi Google voudrait enjoliver la vidéo de présentation s'il détenait vraiment le meilleur algorithme actuel ?

Un “bond en avant”, vraiment?

Mais, même avant la découverte de la supercherie, les éléments factuels fournis par Google n’avaient rien de révolutionnaires comparés à GPT-4 :

Gemini Ultra est un modèle multimodal (ce qui veut dire qu’il peut traiter une demande mélangeant du texte, des images, du son en même temps). GPT-4 aussi.

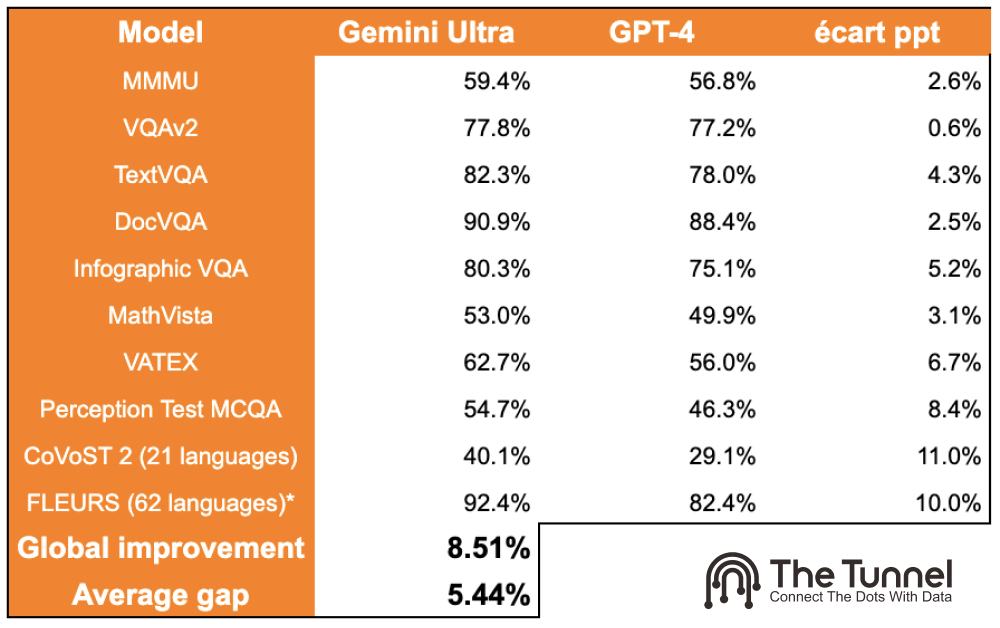

Sur la série de tests sur lesquels on a comparé Gemini Ultra à GPT-4, Gemini obtient de meilleurs résultats, mais, en faisant le calcul, on se rend compte qu’au mieux, Gemini Ultra est meilleur que GPT-4 de 8.5%. C’est une amélioration importante, mais peut-on pour autant parler de “bond en avant”?

Comme GPT-4 avec chatGPT, l’application de Gemini Ultra est un chatbot (qui s’appelle Bard) qui répond à nos questions.

Parler d’un bond en avant est largement excessif. Surtout si on le compare au bond en avant qu’a été la présentation de ChatGPT il y a un an. Ce jour là, Google a compris qu’il avait été dépassé dans la course à la recherche en IA. Après avoir pourtant été pionnière en la matière à l’époque d’AlphaGo de Google Deepmind.

On pourrait presque croire qu’ils essayent de rattraper le temps perdu en s’auto-persuadant, et nous avec, qu’ils ont repris le dessus.

Mais attention à ne pas l’enterrer trop vite !

Une intelligence, c’est des intelligences

Quand même, réussir à être comparable à GPT-4, ce n’est pas rien. Jusqu’à aujourd’hui, peu de modèles arrivent à surpasser GPT-4 sur ce qu’on appelle les benchmarks.

Les benchmarks, c’est une série de tests que l’on soumet aux IA pour évaluer certains aspects de leur intelligence. Ceux qui étaient détaillés dans le tableau précédent.

Il y a par exemple le benchmark “MMU” qui soumet à l’algorithme une série de questions de raisonnement de niveau universitaire, ou encore le benchmark “Infographic VQA” qui évalue la capacité d’un algorithme à comprendre des images.

Cela permet, en quelque sorte, de décomposer le concept d’intelligence et d’en évaluer certaines parties. De même que, chez nous autres, être humains, on peut être intelligents de plein de manières différentes (intelligence sociale, scolaire, émotionnelle, etc.), les algorithmes d’Intelligence Artificielle peuvent être plus ou moins doués sur certains types de tâches.

En l'occurrence, l’un des benchmarks imaginés par Google a été d’organiser un concours de code entre des êtres humains et AlphaCode 2 (l’algorithme de génération de code qui a été créé à partir de Gemini).Résultat : AlphaCode 2 a battu 85% des êtres humains qui concouraient.

Quand on se rappelle de l’histoire d’AlphaGo, on se dit qu’un jour peut-être un AlphaCode pourrait battre tous les êtres humains à coder. Là, il s’agirait d’un bond en avant!

Derrière les algorithmes, l’interface avec l'utilisateur

C’est une chose de savoir faire des raisonnements universitaires, c’en est une autre de savoir répondre à n’importe quelle question.

L’un des enjeux de la compétition que se livrent les entreprises qui développent des produits d’Intelligence Artificielle, c’est la maniabilité et l’ergonomie. Le fait que l’interaction avec l’algorithme soit la plus agréable et efficace possible.

C’est pourquoi avoir un modèle multimodal est quelque chose d’important. Il est tellement plus agréable pour un utilisateur de pouvoir ajouter du son ou de l’image aux questions qu’il pose à l’algorithme.

ChatGPT a connu une adoption de masse depuis un an car même à interfaces égales, la performance de GPT-4 était suffisamment au-dessus des autres algorithmes pour qu’on préfère aller sur ChatGPT.

Mais, à l’instar de ChatGPT qui est l’interface du modèle GPT-4, il y a Bard, qui est l’interface de Gemini Ultra.

Bard est produit par Google, qui, et c’est un euphémisme, arrive à concurrencer les interfaces conçues par Microsoft en général. Mais, en plus, maintenant Bard est également l’interface d’un modèle multimodal au moins aussi intelligent que GPT-4.

Surtout que Google est une entreprise qu’on pourrait aussi qualifier de multimodale avec de nombreux services, Google Drive, Google Cloud Platform, Gmail, Google Chrome, Android, Google Meet…

Bref, vous avez compris : un modèle multimodal qui arrive à comprendre différentes sources de documents (texte, audio, vidéo) par une entreprise multimodale qui produit plein de sources différentes de documents, et qui sait réaliser des interfaces très compétitives : Bard est une vraie menace pour ChatGPT.

Ce que ça dit du monde de l’IA

Un symbole des enjeux actuels

Pour savoir si on parlera de ce mercredi 6 décembre comme du jour où Google a repris la main dans la course de l’IA, il faudra attendre de voir ce que donne Gemini Ultra une fois qu’il sera disponible pour le grand public (annoncé pour début 2024, sans date plus précise).

Mais ce mercredi 6 décembre peut déjà être interprété comme une journée caractéristique des enjeux actuels autour de l’IA. Notamment :

Les enjeux de Marketing 📣: Google a truqué une vidéo et a énormément communiqué sur l’aspect multimodal de son modèle (encore une fois comme GPT-4). Même quand il s’agit d’IA il y a le bon vieux marketing à l’ancienne et il faut toujours garder cela en tête lorsque des entreprises font des annonces grand public.

Les enjeux de protection de données 🔒 : On ne sait pas exactement sur quelles données Gemini a été entrainé, mais avec toute la donnée accumulée par Google avec ses différents produits, des emails aux photo privées, on peut se demander jusqu’où Google a été pour entrainer son dernier modèle.

Les enjeux de capacité de calcul 💻: Gemini, c’est une famille de modèle, et notamment Gemini Nano spécifiquement conçu pour les téléphones portables (ils seront intégrés dans tous les Android). L’une des prouesses de Google est aussi d’avoir réussi à innover dans ce domaine. Les algorithmes n’ont pas été entrainés sur les puces Nvidia (les plus populaires aujourd’hui), mais par des puces fabriquées par Google3. Ce qui leur permet d’être plus efficaces sur le téléphone, entre autres.

Think out of the chatbot

Cet évènement est aussi caractéristique de l’instabilité actuelle dans le monde de l’Intelligence Artificielle. Comme d’habitude tout va très vite. En 24 heures, nous sommes passés de la promesse d'un bond en avant à l'aveu de Google de nous avoir manipulés (ce qui est assez rare).

Et surtout on voit que du jour au lendemain, quelque chose de nouveau pourrait rendre chatGPT obsolète.

Pour y parvenir, cela passera sûrement par une application plus large qu’un simple chatbot. Car oui, l’IA, ce n’est pas seulement chatGPT. Et d’ailleurs, il y a quelques semaines, Google Deepmind, toujours, a développé un algorithme bouleversant la recherche scientifique.

Parce qu’on est en fin de tunnel, je vous épargne les détails que je vous invite à consulter, mais pour faire simple : GNoME (c’est le nom de cet algorithme) a permis de simuler des millions4 d’associations stables de matériaux qui peuvent maintenant être créés et étudiés en laboratoire. Cela ouvre la voie à de nombreuses découvertes scientifiques et technologiques (permettant peut-être un jour de construire des puces encore plus puissantes pour entrainer des modèles encore meilleurs? 🤯)

Cela représente un réel bond en avant, et ce n’est pas un chatbot, pourtant Google a beaucoup plus communiqué autour de Gemini qu’autour de GNoME.

Il faudra encore attendre un peu pour se forger un avis définitif sur Gemini, mais à chaque semaine ses rebondissements, la course de l’Intelligence Artificielle est lancée, et elle est passionnante! ❤️

🎉 Félicitations, vous êtes venus à bout d’un nouveau tunnel! Si ça vous a plu n’hésitez pas à le partager et à vous abonner à na newsletter pour ne pas manquer les prochains.

A très vite 😘

Passionnant de voir combien les innovations en IA progressent , même si certains trichent sur leurs effets d’annonce !!! On veut en savoir plus sur GnOme