L'IA la plus rapide du monde ⚡, le chat 🐈 et comment j'ai choisi ma destination de vacances 🏝️

The Tunnel 2k24#8

Bonjour à tous et bienvenue dans ce tunnel un peu spécial…

Un peu spécial car c’est le premier tunnel qui sera envoyé à plus de 1,000 abonnés 🎉!

Je voulais vous remercier du fond du cœur de me lire, de m’encourager et surtout de parler du tunnel autour de vous. Mon premier levier de croissance est le bouche-à-oreille et c’est grâce à vous. C’est la preuve aussi pour moi que mes tunnels vous apportent de la valeur et j’en suis super fier.

Si jamais vous n’avez jamais partagé de tunnel autour de vous, n’hésitez pas à le faire : plus on est de fous plus on rit et pour moi ça fait une différence fondamentale. Je vous en suis extrêmement reconnaissant ❤️🙏

Allez, ne célébrons pas trop ce millénaire et rentrons toute suite dans le vif du sujet !

Au programme cette semaine 📜:

L’édito

Le dernier acronyme dont vous allez entendre parler

Est-ce que ou vous rappelez de la loi de Moore ? J’en parlais dans le tunnel sur les unités de mesure de la donnée (que je vous invite à lire avant cet édito si vous l’avez manqué).

Bon, pour être tout-à-fait honnête, l’innovation que je m’apprete à vous présenter n’est pas une application stricte de la Loi de Moore. Mais si on extrapole un peu, on pourrait quand même dire que cela va dans le même sens.

S’il ne s’agit pas d’augmenter la densité de transistors sur des circuits électriques comme le prophétisait Moore, je vais vous parler des LPU (pour Language Processing Units) qui sont des proceseurs qui augmentent significativement la vitesse d’exécution des algorithmes d’Intelligence Artificielle.

Allez, accrochez vos ceintures : début de tunnel 🚗🚦.

Groq, le Usain Bolt de l’IA

Vous avez sûrement déjà entendu parler de l’entreprise NVIDIA. Pour rappel, si besoin :

✅ NVIDIA est l’entreprise leader dans la fabrication des processeurs habituellement utilisée pour entraîner des algorithmes d’Intelligence Artificielle (les GPU)

✅ Ses revenus sont en hausse de 265% sur l’année 2023.

✅ L’entreprise vient d’atteindre les 2,000 milliards de dollars de valorisation (pour rappel, OpenAI est à 80 milliards…)

Alors qu’est ce qui pourrait ben troubler un ciel qui parait plus bleu que jamais pour cette entreprise ?

Eh bien, la semaine dernière c’est une entreprise concurrente bien plus petite qui a fait parler d’elle : l’entreprise Groq.

Peut-être que le nom Groq vous dit quelque chose. C’est normal, c’est aussi le nom choisi par Elon Musk pour son agent conversationnel Grok (avec un “k”).

Cela vaut d’ailleurs à Musk d’être accusé par les dirigeants de Groq de plagiat, l’entreprise au “q” ayant été créée la première. Pour la petite histoire, le verbe “to grok” est un néologisme inventé par l’écrivain Robert A. Heilein, dans son roman Starnger in a strange World (1961), qui signifie “tout comprendre”. Le nom idéal pour parler d’IA…

Il y a néanmoins une grande subtilité entre les deux. Là où le Grok d’Elon Musk est un algorithme, Groq est une entreprise qui fabrique des composants informatiques (comme NVIDIA).

Ils ont beaucoup fait parler d’eux la semaine dernière donc après avoir sorti une vidéo montrant comment un chatbot tournant sur une machine équipée des composants Groq était dix fois plus rapide que chatGPT.

La vitesse d’inférence (on appelle “inférence” l’étape où l’algorithme travaille pour trouver sa réponse) est multipliée par dix, parce que les cartes graphiques utilisées ne sont pas de GPU, mais des LPU (pour Language Processing Unit).

Quand on lit le mot “Language”, on se dit en effet qu’il pourrait être opportun que des LLM (Large Language Models) les utilisent.

LPU, GPU, TPU ou autres DPU, mais de quoi s’agit-il ?

Vous aurez remarqué que dans tous ces acronymes, on retrouve toujours les lettres “PU”. Dans tous les cas, “PU” signifie “Processing Unit”, autrement dit “Processeur”.

Les processeurs, ce sont les composants électriques qui font de votre ordinateur votre ordinateur.

Mais peut-être avez-vous un modèle d’ordinateur particulièrement efficace pour jouer à des jeux vidéos, pour entraîner des algorithmes d’Intelligence Artificielle ou simplement polyvalent.

Les caractéristiques de votre ordinateur vont dépendre du type de processeurs dont il est équipé. Et donc, dans le contexte de ces acronymes, de la première lettre qui vient avant le “PU”.

Parmi les différentes options, il y a :

1️⃣ CPU : Le CPU est un peu un cas à part car il fait partie de tous vos ordinateurs. En français, on appelle ça la “carte mère”. C’est le composant électrique principal qui vous permet de traiter les opérations basiques de votre ordinateur.

2️⃣ GPU : Le “G” de GPU veut dire “Graphic”. Il s’agit d’un composant qui permet à votre ordinateur de faire des belles représentations en 2D ou en 3D. Il fonctionne à côté d'un CPU sur les ordinateurs sur lesquels il se trouve. Il est très puissant. Si puissant qu’aujourd’hui encore la tâche la plus difficile à réaliser par un ordinateur (entraîner un algorithme d’Intelligence Artificielle) se fait sur un GPU.

3️⃣ TPU : Le “T” ici veut dire “Tensor”. Il s’agit d’un processeur qui a été inventé par Google pour réaliser des tâches complexes de Machine Learning.

4️⃣ DPU: Avec un “D” comme “Data”. Ce sont des processeurs particulièrement efficaces pour effectuer du stockage de données. Particulièrement utile dans des data centers.

5️⃣ Et le nouveau venu le LPU : Le “L” veut dire langage donc et la seule entreprise au monde à en détenir aujourd’hui est l’entreprise Groq.

Encore une tonne d’applications qui deviennent possibles

Les performances de ces processeurs sont époustouflantes. Le nombre de tokens (1 token ~ 0.7 mots) générés par seconde explose à 185 sur des modèles de 70 milliards de paramètres (contre 66 au mieux sur un GPU).

Avec le modèle Mixtral, Groq peut même générer 500 tokens par secondes. C’est énorme et ça ouvre la voie à de multiples nouvelles applications :

🔄 Pour faire fonctionner des LLM entre eux. Si un LLM attend le résultat d’un autre LLM, qui attend lui même le résultat d’un autre LLM et ainsi de suite le nombre de tokens générés par seconde peut rapidement devenir critique. Avec Groq il devient plus envisageable de faire fonctionner des LLM à la chaîne.

🗣️ Pour générer des paroles quasiment humaine. Lorsqu’une IA parle aujourd’hui, c’est assez facile de la reconnaître. Ses phrases sont saccadées et il lui est impossible de se mettre à parler très très vite. Avec Groq, c’est maintenant possible.

Il doit encore y avoir beaucoup d’applications imaginables, mais rien que ces deux là méritent qu’on s’en réjouisse. Et qu’on s’enflamme un peu pour les nouveaux venus : Les LPU.

Les actualités à ne pas manquer

🖼️ Stability AI annonce l’arrivée de Stable Diffusion 3. Stable Diffusion, ça ne vous dit rien ? Ça tombe bien, j’en parlais dans mon tunnel de la semaine dernière. Si on avait un doute : l’IA, ce n’est pas seulement des chatbot. Avec une version encore plus élaborée de Stable Diffusion (déjà utilisé des milliards de fois dans ses précédentes versions, les applications text-to-image vont pulluler.

🌐 Google se lance dans l’Open Source. Et oui, aujourd’hui pour être cool, il faut faire de l’Open Source. Après un nouveau couac concernant la génération absurde d’images de son modèle fermé Gemini, Google a annoncé la semaine dernière un modèle Open Source qui s’appelle Gemma et qui semble assez performant. C’est une bonne nouvelle de voir Google revenir à l’Open Source alors que Tensorflow, la librairie Python Open Source de Google est une référence en Machine Learning depuis quelques années déjà.

💰 Une nouvelle levée pour une entreprise qui pourrait devenir une référence. L’entreprise DatalogyAI a levé 11 millions de dollars pour développer son nouvel outil de curation de données pour entraîner des modèles. Vous voulez mon avis ? Je ne comprends pas pourquoi cette entreprise n’a pas levé encore plus d’argent dans un monde où selon des études, 45% du temps de travail des data scientist est consacré à la curation et au nettoyage des données.

La Success Story de la semaine

Mistral AI prend tout le monde de cours

Savez-vous ce qu’est le French Flair ? C’est une expression qu’on utilise pour décrire la façon française de jouer au rugby entre la surprise permanente et la folie. Alors que sur les terrains de rugby ce n’est pas la joie pour les bleus, une entreprise se la joue french flair : Mistral AI 🇫🇷.

Pourquoi ça ? Parce que la semaine dernière, contre toutes attentes, l’entreprise française, connue comme étant une pionnière mondiale en terme de modèles Open Source a annoncé un nouveau modèle… fermé !

Ce modèle fermé est accessible via un chat (gratuit, pour l’instant), nouveau concurrent français de chatGPT qui s’appelle “Le chat” (prononcez le comme vous voulez, mais pour moi le “t“ est muet 😉).

Autre surprise concoctée par Mistral : ils viennent d’annoncer un partenariat avec Microsoft et le modèle ne sera accessible que sur les serveurs Azure.

Cette nouvelle doit se lire sous différents angles selon moi :

💼 Ce n’est pas parce qu’une entreprise fait de l’Open Source qu’elle n’a pas le droit de faire des modèles fermés pour gagner de l’argent. Au contraire, c’est en montrant à des investisseurs qu’une entreprise Open Source est aussi capable d’avoir un vrai business model que les investissements vont se multiplier

🐢 Google est vraiment en train de perdre la course à l’IA. Il ne faut pas parler trop vite, il y a encore 2 ans Microsoft semblait être une entreprise un peu vieillissante et force est aussi de constater que la plupart des grands talents IA actuels ont fait un passage à un moment ou à un autre chez Google Deepmind (dont Arthur Mensch le fondateur de Mistral). Mais personne n’est surpris de voir Microsoft être l’entreprise avec laquelle Mistral a signé son partenariat.

🐱 “Le chat” et “Au large” comme titre pour les annonces faites par Mistral cette semaine : la francophonie est de retour dans le monde du numérique !!

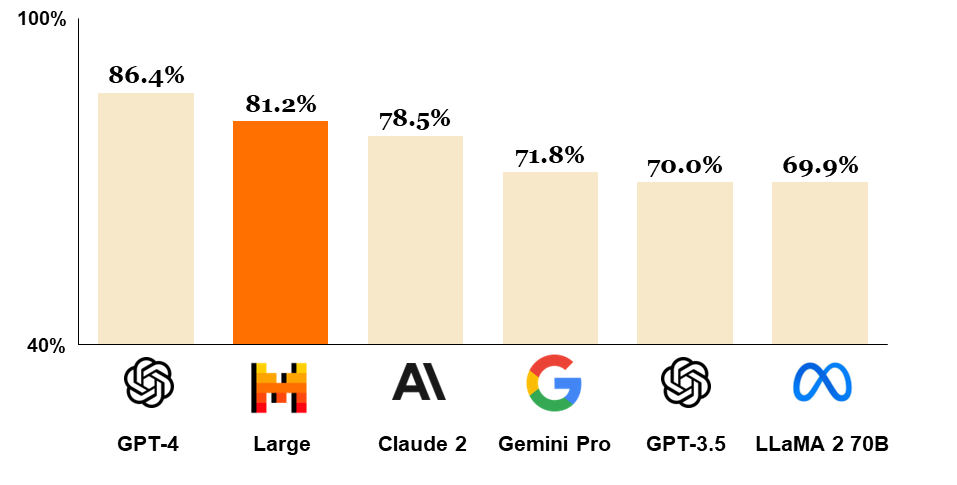

Bref, Mistral continue de bluffer le monde entier et réalise des prouesses hallucinantes avec moins d’un an d’ancienneté et “seulement” 300 millions investis. Et, si vous ne payez pas chatGPT pour avoir accès à GPT-4, regardez bien l’image ci-dessus : il est temps d’utiliser “le chat” qui est plus performant que GPT 3.5 🐈.

Le prompt de la semaine

Où allez-vous passer votre été ?

Je vous partage un prompt très personnel cette semaine, mais qui pourrait vous servir et vous inspirer. Nous sommes le 1er mars et si vous voulez éviter de payer très cher pour vos vacances d’été, vous feriez bien de vous y prendre dès maintenant.

Mais bon si vous ne savez pas où aller, vous n’irez pas bien loin… C’était mon cas jusqu’à ce week-end et une petite discussion que j’ai eu avec chatGPT.

Il ne s’agit pas de lui demander de décider pour vous, mais de vous faire des propositions qui correspondent à vos critères pour choisir une destination parmi les milliers de possibilités que vous avez devant vous.

Un grand avantage de cette méthode est que chatGPT ne va pas nécessairement vous proposer des destinations mainstream où tous les français se retrouvent pour jouer à la pétanque en écoutant Aya Nakamura.

Avec mes critères, voici le prompt que je lui ai soumis

Tu es un agent de voyage spécialisé pour les vacances d'été (août). Nous sommes un couple de jeunes trentenaires sans enfants, amoureux de la nature.

On cherche un voyage avec de la randonnée, de la nature, de l'authenticité, mais aussi un peu de confort et de simplicité. Nous cherchons une destination qui ne nécessite pas beaucoup d'organisation.

Nous avons un budget modéré (800 euros par personne en comprenant transport, hôtel, nourriture, etc.) . Nous partons de Paris. Que nous conseilles-tu pour notre voyage du 1et au 15 août ?

Résultat des courses ? Nous partons en Slovénie 🇸🇮!

Je n’y aurai jamais pensé tout seul pour être honnête, et après avoir vu quelques photos de paysages, j’attends cet été avec impatience… ⏳

Le papier de recherche de la semaine

LongRoPE: Extending LLM Context Window Beyond 2 Million Tokens

Que novembre 2023 semble lointain… À l’époque Sam Altman venait de se faire mousser lors du Dev Day, évènement organisé par OpenAI pour annoncer les grandes nouveautés à venir pour l’entreprise qui vient de dépasser les 80 milliards de valorisation.

Parmi les choses dont Sam Altman était le plus fier : l’augmentation de la context window de chatGPT à 128,000 tokens. Autrement dit : Sam Altman était très fier d’annoncer que chatGPT serait en mesure de traiter des prompts de 128,000 tokens (soit environ 90,000 mots).

La semaine dernière, Google a présenté son dernier modèle Gemini 1.5, capable de traiter des prompts d’1 millions de tokens. Au départ, puisque cela venait de Google, et que Google a largement perdu en crédibilité ces derniers temps en terme d’IA, on avait du mal à y croire. Avant ce nouveau papier de recherche (publié par Microsoft…) clamant avoir trouvé une méthode permettant d’étendre la context window des LLM à plus de 2 millions de tokens.

Je vous passe les détails trop techniques car on est en fin de tunnel et que franchement, même en début de tunnel, j’aurais eu du mal à vous les expliquer, mais l’idée est la suivante :

Les chercheurs ont trouvé une méthode permettant de fine-tuner un modèle “classique” pour étendre progressivement la taille des textes sur lesquels il est entraîné sans faire exploser la force computationnelle nécessaire. Avant de réaliser un dernier fine-tunning qui permet au modèle d’être aussi précis que s’il avait reçu des prompts d’une taille maximale de 8,000 tokens.

C’est extrêmement intéressant car plus on a de tokens dans les prompts, plus on peut faire faire des choses folles à l’IA, comme :

💻 Lui fournir une entière code base et lui poser une question dessus.

📚 Lui fournir une quantité astronomique de documents à résumer.

🎥 Lui donner la possibilité d’accepter des prompts non textuels comme des images ou des vidéos.

Bref, la recherche continue à un rythme effréné et si certains en doutaient encore : les applications impossibles aujourd’hui seront très rapidement possibles demain.

Et voilà, fin de tunnel, vous pouvez sortir 👏.

Merci encore de m’avoir lu. Si vous avez aimé ce tunnel, partagez le, je vois toutes les personnes qui cliquent sur le bouton partage et je vous en suis extrêmement reconnaissant.

Et bien-sûr, si vous êtes nouveau ici, abonnez-vous pour ne rien rater des prochains tunnels !

Je vous souhaite une excellente fin de semaine ❤️

Toujours plus quali ! Et vive Mistral 🇫🇷