InstructGPT 📚, le GPT Store version Open Source 🆓, et comment lutter contre les fake news avec l'IA ❌

The Tunnel 2k24#5

Bonjour à tous et bienvenue dans ce 5ème tunnel de l’année 👐. La barre des 700 abonnés a été dépassée et la croissance continue sur un rythme assez effréné… Next step : 1000 abonnés!! Mais avant ça, c’est parti pour un tunnel !

Au programme du jour :

💡 Comment chatGPT arrive-t-il à donner des réponses si pertinentes ?

🎁 Hugging Face lance une version gratuite et Open Source du GPT Store

🕵️♂️ Le papier de recherche sur la détection des fake news par de l’IA

L’édito

Comment GPT est devenu chatGPT ?

Que s’est-il passé entre juin 2018 et novembre 2022 ? Ou, posé autrement : pourquoi a-t-il fallu attendre 4 ans et demi pour passer de GPT-1 à chatGPT ? La réponse tient dans une découverte, annoncée par OpenAI en janvier 2022 et dont vous n’avez probablement pourtant jamais entendu parler : les modèles du type InstructGPT.

On va revenir plus en détail sur ce qui se cache concrètement derrière ce type de modèles, mais ce que vous devez retenir si vous n’avez pas la force de vous lancer dans une explication plus détaillée c’est qu’avec InstructGPT, OpenAI a réussi à corriger les erreurs que commettait le modèle GPT et qui l’empêchait d’avoir un usage grand public. En effet, sans InstructGPT, chatGPT répondrait à côté de la plaque une fois sur deux.

Bon allez, je suis sûr que vous avez envie d’en savoir plus, accrochez vos ceintures et mettez vos feux 🚦: le tunnel commence pour de vrai !

La première étape pour fabriquer chatGPT : lui faire comprendre nos questions

Qu’un être humain comprenne un autre être humain qui parle une langue différente, c’est déjà difficile. Alors imaginez une machine, qui parle en 0 et en 1, qui doit comprendre un être humain. C’est encore plus dur.

Heureusement, on a réussi à trouver une méthode pour faire comprendre à une machine le langage humain. Cette méthode s’appelle le Natural Language Processing (NLP).

Le NLP, ça ne date pas d’hier. Des chercheurs américains ont commencé à s’intéresser à cette discipline dans les années 1950 pour essayer de faire comprendre et traduire à une machine des documents écrits en russe.

Depuis, la guerre froide a pris fin, mais la volonté de faire comprendre du langage humain à une machine n’a pas disparu. Aujourd’hui, pour qu’une machine arrive à comprendre ce qu’on lui demande, on effectue une vectorisation des mots.

Je ne vais pas ici m’étendre sur la façon dont on arrive à faire du Natural Language Processing avec de la vectorisation. Parce que ce n’est pas le but de cet édito, et aussi parce que nous avons donné une explication très détaillée dans Le Plongeoir il y a dix jours. Si vous l’avez raté, je vous recommande vivement de piquer une tête dès maintenant.

Si vous n’avez pas l’envie ou le temps de le lire, retenez une chose : grâce au NLP, on est capable de faire en sorte que chatGPT comprenne les questions qu’on lui pose. Ni plus, ni moins.

La deuxième étape pour fabriquer chatGPT : lui apprendre à répondre de façon pertinente

“Le gouvernement vous a entendu et vous a compris” déclarait Gabriel Attal le 26 janvier dernier devant des agriculteurs qui avaient formulé un ensemble de demandes. Pourtant dès les heures qui suivirent cette déclaration, les différents syndicats agricoles décidèrent de poursuivre leur mouvement de revendication.

Car oui, comprendre et répondre de façon pertinente, c’est différent. Alors, évidemment quand on est Gabriel Attal qui doit répondre à la colère des agriculteurs, c’est un peu difficile.

Mais, quand c’est chatGPT qui doit répondre à des questions plus simples, on peut facilement savoir si ses réponses sont pertinentes ou pas.

Eh bien, figurez-vous qu’avant la découverte d’InstructGPT - dont on parlait en introduction -, chatGPT comprenait bien les questions qu’on lui posait, mais répondait souvent à côté de la plaque, comme vous pouvez le voir dans l’exemple ci-dessous.

Alors, c’est quoi InstructGPT ?

C’est un modèle dérivé de GPT qui a subi une surcouche finale d’entraînement pour être plus pertinent dans ces réponses.

🚨Accrochez vos ceintures, nous entrons dans une zone de turbulence un peu technique🚨

Cette surcouche finale d’entraînement a été faite avec une méthode bien précise : Le Reinforcement Learning with Human Feeback (RLHF).

Le RLHF consiste en la chose suivante :

📚 On montre au modèle un ensemble de questions/réponses pertinentes pour le réentraîner. On dit qu’on procède au fine-tunning du modèle.

🤖➕👨⚖️ On entraîne un deuxième modèle qui est capable de dire au premier modèle si ses réponses sont plus ou moins cohérentes. Pour ce faire, on pose plusieurs fois la même question à chatGPT et on demande à un être humain de classer les réponses de la plus pertinente à la moins pertinente. On dit qu’on entraîne un modèle de Reward (avec feedback humain).

🔄 À partir de là, on laisse le modèle s’auto-poser des questions et le reward model lui dire à chaque fois si la réponse qu’il a donnée était plus ou moins pertinente. C’est ainsi que le modèle apprend à devenir de plus en plus pertinent.

Ce n’est pas la première fois que l’on parle de Reinforcement Learning, rappelez-vous du tunnel sur Q*.

La différence ici est que le reward model est entraîné sur la base d’un ressenti humain (et pas sur quelque chose de totalement objectif, comme dire si une partie de jeu de Go est gagnée ou perdue).

C’est ce qui nous a permis de créer un modèle qui, non seulement comprend nos questions, mais qui y répond pertinemment. Enfin, presque…

La prochaine étape pour un chatGPT encore plus intelligent : combattre les biais

Presque, car derrière le RLHF et InstructGPT, il y a quand même des êtres humains qui classent les réponses données par chatGPT selon leurs propres systèmes de valeur.

Demandez à Marine Le Pen ou à Jean-Luc Mélenchon de noter des réponses à des questions posées et vous verrez que leur classement ne devrait pas souvent être le même.

Donc si vous demandiez à Marine Le Pen ou à Jean-Luc Mélenchon de vous aider à entraîner un modèle en donnant leur feedback, vous aurez finalement 2 modèles qui répondraient quelque chose de différent à la question “Y’a-t-il un problème d’immigration en France ?”.

Dire que chatGPT est un peu trop “woke” (comme Elon Musk notamment 🤡), c’est dire que les personnes qui ont donné leur feedback lors de l’entraînement sont trop “woke”.

Mais personne n’a un jugement de valeur totalement objectif et parfait, donc aucun modèle n’est non plus parfait. Certains ont des idées fixes (essayez de demander à Ernie, le chatbot développé par le géant chinois Baidu si Taiwan c’est la Chine, vous verrez qu’il n’y a pas de nuances dans son jugement). D’autres modèles ont des biais qui sont le fruit des biais inconscients de ceux qui l’ont entraîné…

Bref, la naissance d’InstructGPT a tout changé pour OpenAI qui a pu sortir un chatbot qui comprenait les questions qu’on lui posait et qui y répondait très pertinemment.

Mais un modèle sans biais n’existe pas, le savoir et s’en rappeler permet de cultiver son sens critique face aux réponses fournies par l’IA…

Les actualités à ne pas manquer

🇯🇵 L’entreprise japonaise Sakana a reçu un superordinateur de la part de son gouvernement pour accélérer la recherche. Créée seulement il y a quelques semaines, je suis convaincu qu’on entendra reparler de cette entreprise sur laquelle le Japon compte énormément. À quand un modèle japonais grand public ?

🌌 Mistral laisse fuiter un mystérieux modèle “quantique”. La toile s’est enflammée la semaine dernière lorsqu’un nouveau modèle inconnu est arrivé sur Hugging Face. Ce modèle, du nom de Miqu (pour Mistral Quantique) est en fait un modèle d’essai utilisé par Mistral qui a reconnu la fuite. En annonçant que ce modèle qui a bluffé tout le monde était loin derrière ce sur quoi ils travaillaient maintenant. Avant de conclure par un “Stay tuned”. Alors, Stay tuned !

🛒 Hugging Face lance un concurrent au GPT Store en version Open Source. Bah oui, y’a pas de raison. Si vous refusez toujours de payer la version payante de chatGPT, rendez-vous sur Hugging Face pour essayer leurs assistants. Je vous prépare un post Linkedin prochainement pour sélectionner les meilleurs que vous pourriez utiliser. Si vous ne me suivez pas encore, c’est le moment de le faire !

La Success Story de la semaine

Arc : le browser qui peut être utilisé par une IA

C’est l’une des limites de chatGPT et de ses concurrents comme Bard ou Perplexity aujourd’hui. Si ces chatbots ont tous accès à internet, on a souvent l’impression que leur capacité à surfer sur le web est limitée 🏄.

Et quand bien même chatGPT arrive à vous sortir des informations qu’il trouve via le moteur de recherche Bing ou Bard vie Google, pas question pour les chatbots de faire autre chose que retranscrire l’information.

C’est cette limite qu’a voulu dépasser The Browser Company sur son nouveau browser Arc. Arc est un browser qui entend concurrencer Google en étant un browser dit “AI first”. Et pour y parvenir, ses développeurs sont en train de travailler à une version qui pourrait être utilisée à 100% par un agent IA.

Si cette technologie n’est pas encore publiquement disponible, lorsqu’elle verra le jour il sera bien plus facile d’optimiser l’interaction entre l’IA et internet en général. Ce qui ouvre la voie à une myriade d’applications. Je vous en reparlerai sûrement lorsque ça arrivera, alors n’arrêtez pas de lire bien consciencieusement mes tunnels d’ici là !

Le prompt de la semaine

Ne prenez pas chatGPT pour ce qu’il n’est pas.

L’être humain est incorrigible, il est fainéant 🙈. Alors lorsqu’un outil qui peut faire autant de choses que chatGPT est mis à notre disposition, on adore. Le problème c’est qu’on peut aussi avoir tendance à pousser le bouchon un peu trop loin et se mettre à demander l’impossible.

Oui chatGPT est créatif, mais non il ne peut pas tout inventer. Il a besoin d’avoir les instructions les plus claires et les plus détaillées que possible.

Par exemple si vous demandez à chatGPT d’écrire pour vous une petite histoire à raconter, non seulement il pourrait partir dans tous les sens, mais surtout l’histoire qu’il racontera sera superficielle car il choisira quelques détails au hasard mais ne prendra pas le risque d’être trop spécifique.

C’est à vous de décider d’un scenario, d’un nombre de personnage, d’un élément à intégrer, d’une morale à faire passer. Et avec toutes ces informations, il sera capable de faire quelque chose d’incroyable.

💌 Ainsi, pour lui faire faire un poème à adresser à la personne que vous aimez, par exemple, au lieu de lui demander :

Écris-moi un poème

Demandez-lui :

Écris-moi un poème d’amour en alexandrins qu’un homme écrit pour la femme qu’il aime. Le poème doit prendre place dans un cadre romantique. Il ne doit pas comporter plus de 15 vers.

Je veux que les éléments de la nature soient mis en valeur et que la personne à qui est adressé ce poème ait envie de s’évader en l’écoutant.

La morale de l’histoire que tu dois raconter est qu’en amour, comme dans la vie, il est préférable d’être optimiste et de se tromper que d’être pessimiste et d’avoir raison.

Et voilà le résultat :

Dans le jardin où fleurit l'espoir sous l'azur grandiose,

Où murmure le ruisseau, caressant les roses,

Je t'offre ces vers, nés d'un cœur fervent et pur,

Pour qu'en eux tu trouves l'évasion, l'amour sûr.La lune veille, éclatante, sur notre destinée,

Sa lumière d'argent guide notre éternité.

Les étoiles, témoins silencieux de notre amour,

Brillent d'un feu doux, promettant toujours.Marchons, main dans la main, sur ce chemin fleuri,

Où le doute s'efface, remplacé par l'envie

De croire en demain, malgré les ombres du passé,

Car aimer, c'est vivre, et se tromper, c'est espérer.Mieux vaut errer ensemble dans l'optimisme,

Que d'avoir raison seul, dans un triste abîme.

Mon amour, dans ce monde vaste et beau,

Je choisis l'espoir, avec toi, haut et beau.

N’attendez plus, travailler votre prompt et écrivez un poème d’amour à la personne que vous aimez. ❤️

Le papier de recherche de la semaine

Bad Actor, Good Advisor: Exploring the Role of Large Language Models in Fake News Detection

L’avènement de l’IA Générative s’accompagne de nombreux défis, que l’on évoque chaque semaine au cours de ces tunnels. Parmi l’un d’eux la génération et la diffusion en masse de potentielles fake news créées par des IA. Mais pourrait-on utiliser l’IA pour détecter automatiquement une fake news ?

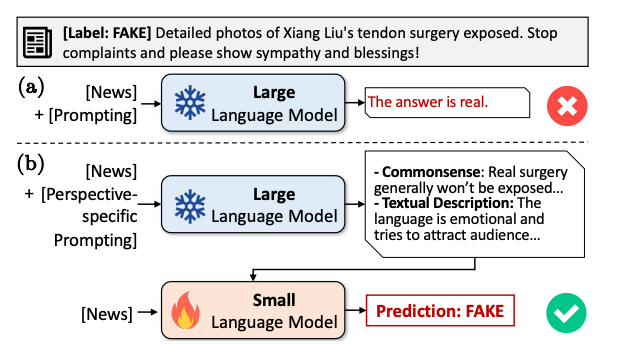

C’est en tout cas le thème exploré par ce papier de recherche. Le constat est le suivant :

Les modèles les plus performants actuellement pour détecter des fake news sont des petit modèles de langage (SLM) comme le modèle BERT par exemple (76.5% d’efficacité sur le dataset utilisé par les chercheurs). Les grands modèles de langage (LLM) n’arrivent pas à se montrer aussi efficaces pour détecter les fake news (70.2%).

Pourtant les grands modèles de langage ont des caractéristiques qui leur permettent de réaliser beaucoup plus de choses que les petits modèles de langage (SLM).

L’idée de ce papier de recherche est de créer une nouvelle méthode de détection de fake news qui fonctionnerait comme suit :

🔍 On demande à un LLM de décrire les éléments rationnels qui pourraient permettre de conclure quant à la véracité ou non d’un fait.

🚫 On demande à un SLM à partir du fait et des éléments rationnels fournis pour le LLM de conclure si le fait est une fake news ou non.

Résultat ? 87.8% d’efficacité sur le dataset en question. C’est-à-dire une amélioration de 15% !

Alors certes, on a le droit de voir le verre à moitié vide : même avec cette méthode, le détecteur de fake news commet 12.2% d’erreur. Ce qui n’est pas acceptable quand on connaît les conséquences que peuvent avoir les fake news en politique, dans le domaine de la santé ou encore d’un point de vue économique.

Mais il y a quelque chose de très intéressant néanmoins, car :

🤝 Comme pour tout ce qui se passe en IA, les recherches se suivent et on progresse à chaque fois. Quel sera le pourcentage de succès dans la détection de fake news pour les prochaines méthodes qu’on inventera dans un an, cinq ans ou dix ans ?

🧩 Comme souvent, une des méthodes utilisée ici est de décomposer la problématique générale et d’entraîner différents modèles à travailler ensemble. C’est souvent par cette voie que les chercheurs font des découvertes révolutionnaires

Et voilà, ce cinquième tunnel touche à sa fin. Bravo si vous avez été jusqu’au bout, cette édition était particulièrement technique. Ça fait du bien de temps en temps. N’hésitez pas à me dire comment vous l’avez trouvé, à vous abonner, et à partager partout autour de vous.

À la semaine prochaine pour un nouveau tunnel ❤️

Bravo, j’adore ce post qui allie technique, pratique, humour

Mention spéciale aujourd’hui pour le poème ! 👏👍